Salut tout le monde!

Ça fait un petit bout depuis mon dernier update. ![]() Vous allez voir, je n’ai pas chômé et les choses commencent à devenir assez sérieuses!

Vous allez voir, je n’ai pas chômé et les choses commencent à devenir assez sérieuses! ![]()

Au début, j’étais un peu timide face à l’automation. Je n’ai aucune formation en électronique ou en design industriel. Je suis litéralement parti de la case départ!

Pour ceux qui me suivent depuis un certain temps, vous n’allez pas être surpris d’apprendre que j’ai voulu courir avant d’apprendre à ramper, que j’ai été beaucoup trop intense et que le 9/10e de ce que j’ai fait s’est retrouvé à la poubelle…

… et j’ai adoré chaque instant!

Mais, avec les outils comme Cursor.com et Claude Code, ça m’aide à m’attaquer à des projets beaucoup plus gros et ambitieux.

Le meilleur exemple est avec l’algorithme de détection des visages et des poses que j’ai partagé plus tôt.

En disant que j’allais éventuellement ajouter du face/body tracking, je n’avais AUCUNE idée de ce que ça impliquait.

Je me suis juste dit:

![]() Ça a l’air d’être un cool projet, je vais avoir du fun!

Ça a l’air d’être un cool projet, je vais avoir du fun!

![]() C’est une compétence que je vais pouvoir ré-utiliser plus tard. Ça fait du sens de L’intégrer à mon coffre d’outil.

C’est une compétence que je vais pouvoir ré-utiliser plus tard. Ça fait du sens de L’intégrer à mon coffre d’outil.

![]() Ça va apporter de la valeur à mes clients.

Ça va apporter de la valeur à mes clients.

Je n’avais aucune idée de combien de temps ça me prendrait ou même si j’allais être capable. J’estimais que ça allait me prendre AU MOINS un mois à temps plein!

Turns out, j’ai réussi à mettre ça sur pied en 3-4 soirs à l’aide de Cursor!

Ça fonctionne déjà assez bien — j’ai fait une vidéo sur Facebook pour vous montrer à quoi ça ressemble.

Attention, je m’apprête à t’expliquer beaucoup trop de choses! Si ça t’intéresse, « MY MAN!!! » clique sur le petit triangle et amuse-toi en lisant ma struggle porn.

Par contre, si tu es une personne normale, skip le tout sans te sentir mal!

Grosse explication qui va intéresser 1% de la population

En gros, voici comment ça fonctionne:

Il y a 4 étapes en cascade:

-

On downscale l’image en 480p, noir et blanc.

-

Un script détecte s’il y a un humain et découpe un rectangle autour de la personne.

-

S’il y a une personne, le script tente de détecter un visage et de tracer un rectangle autour.

-

S’il y a un visage, un dernier script détermine l’emplacement des yeux, nez, bouche, etc.

Chaque algorithme ne traite que les pixels à l’intérieur du rectangle de l’étape précédante. L’Idée est de réduire le nombre de pixel à analyser puisque l’ordinateur va devoir compléter ça 24 fois par seconde pour chaque caméra. La latence est super importante!

Pour les curieux, l’algorithme que j’utilise pour ça est YOLOv8n et MediaPipe.

Le premier fait la détection + les rectangles, le 2e crée une map 3d du visage.

Une fois que le script a fait son travail, c’est le temps de déterminer:

![]() /

/ ![]() Est-ce que la personne regarde la caméra? En estimant la rotation de la tête (Yaw, Pitch, Roll) à partir des triangles entre les coins de yeux, la position de l’iris, le nez et la bouche, etc.

Est-ce que la personne regarde la caméra? En estimant la rotation de la tête (Yaw, Pitch, Roll) à partir des triangles entre les coins de yeux, la position de l’iris, le nez et la bouche, etc.

![]() /

/ ![]() Est-ce que la personne regarde parle? En calculant l’oscillation (le nombre de vas et vien) la variation des coins de bouche et la distance entre les lèvres du haut et du bas.

Est-ce que la personne regarde parle? En calculant l’oscillation (le nombre de vas et vien) la variation des coins de bouche et la distance entre les lèvres du haut et du bas.

L’idée est éventuellement d’utiliser ça pour changer les angles de caméras en temps réel.

Présentement, j’utilise un logiciel qui analyse le volume des micros, mais ça coupe parfois au mauvais endroit et ce n’est pas tous mes clients qui sont satisfaits.

En utilisant l’IA, je pourrais me faire un petit système de point beaucoup plus robuste.u

Exemple:

-

Quelqu’un regarde la caméra, +5 points par personnes.

-

On voit quelqu’un parler, +5 point par personnes.

-

On passe les micro dans une fonction qui retourne entre 0 et 5 en fonction du nombre de décibels.

-

Si la caméra est l’angle actif, je pourrais avoir une fonction qui prend le nombre de seconde écoulé depuis pour jouer avec le score. Ex: max(0, 5 - n)

Le switch automatique des caméras n’est pas encore fait, mais ça ne devrait pas être très long une fois que tout va être en place!

Pour l’instant, ce qui est fait est:

-

Cadrage automatique (X,Y) de la personne à 3 endroits cibles: le tiers supérieur droit, supérieur centre, supérieur gauche.

-

En fonction de l’angle du visage (plongé/contreplongé) ajustement de la hauteur de la caméra.

-

En fonction du pourcentage du rectangle du visage dans l’image, ajuster le zoom de la caméra.

Ça marche VRAIMENT bien. Je suis surpris!

La seule chose qui ne fonctionne pas super bien, c’est le contrôle de la hauteur. Mes robocaméras ne sont pas très fluides sur l’axe vertical alors le rendu est boff… On dirait que le caméraman est épileptique!

J’espère corriger ça dans la prochaine version (V4) du robocaméra!

Présentement, la hauteur des caméras est gérée par un simple système de « rack and pinion » imprimé en 3d.

En écoutant cette vidéo YouTube (à 1 min 22), j’ai découvert les « Roller pinion ».

L’idée est de remplacer les dents d’un engrenage par un cylindre qui tourne librement. Comme ça, lorsqu’il fait contact avec le rack, le cylindre peut tourner, ce qui élimine la friction.

C’est assez difficile à trouver « off the shelf ». Une seule compagnie en offre (Nexen) et le coût monte à plus de 1000$. ![]()

J’ai donc demandé l’aide de ChatGPT (lien vers la conversation) pour créer ce prototype imprimmé en 3D.

(Oui, j’ai appris à faire des animations en CAD juste pour ce post! ![]() )

)

J’ai fait imprimer et ça fonctionne super bien! Je vais essayer d’incorporer le principe à la V4 de la robocaméra.

Parlant de V4… Je pense que ça vaut la peine que je fasse un petit recap du progrès depuis les années!

V1:

-

Arduino Uno R3 comme contrôleur

-

2 servo un par dessus l’autre avec un actuateur linéaire pour la hauteur contrôlé par un H-Bridge.

-

Détecteur de distance à ultrason (HC-SR04) pour le calcul de la hauteur.

V2:

-

Même fonctionnement que la V1, mais plus sleek!

-

Pour rendre plus compact, j’ai échangé le Uno R3 par un Arduino Nano IOT (Je ne recommande pas, le Wifi drop non-stop!)

V2.1

- On ajoute un balancier pour le pivot et une gearbox fait maison pour la rotation.

V3

-

Remplacer les servomoteurs cheap par des Nema17 (des moteurs ultra précis d’imprimante 3d).

-

Remplacé l’actuateur linéaire pour un contrepoids et un Nema17 qui active un « rack and pinion ».

-

Je détecte l’angle de la caméra à l’aide d’un encodeur magnétique.

-

J’ai remplacé les arduino Nano IoT par des Uno R4 Wifi.

V3.1

-

Ajout d’une base pour retenir les fils.

-

Ajout d’un module pour contrôler le zoom.

V3.2

-

J’ai changé tous les engrenages pas des sangles.

-

Ajout de roller bearings pour me permettre de serrer la tête en place.

-

J’ai enlevé les capteurs magnétiques qui calculent la position des moteurs et j’ai plutôt mis des limit switches. C’est (beaucoup) plus fiable!

V3.3

-

J’ai fait une cage de caméra custom où tout est intégré. En plus de sauver de l’espace, la caméra reste plus droite (les autres ont un tilt d’environ 1 degré sur l’horizon).

-

Grosse amélioration au niveau de la facilité d’assemblage! Le corps est en 5 parties. Comme ça, je peux changer la tête sans avoir à tout défaire!

La grosse innovation est surtout au niveau du logiciel!

Bien que le protocole de communication est resté le même (MQTT), le firmware est DRASTIQUEMENT différent.

On est passé de 372… à 4 235 lignes de code!

Pourquoi faire x11 sur la complexité? Simple… Pour être en mesure de donner les contrôles à un IA, il fallait créer un système qui permettait de faire bouger tous les axes en même temps sans interuptions.

J’ai détaillé le problème un peu plus tôt dans le post (le 11 février).

En gros, j’avais prévu ajouter un 2e petit ordinateur. Un allait gérer les communications avec le serveur, l’autre allait gérer le mouvement des moteurs.

Un bon dimanche, une idée de génie s’est manifestée dans la douche! Pourquoi est-ce que je n’achète pas un clône d’Arduino Uno board qui a déjà 2 processeurs intégrés?

Mon cerveau s’est mis à bouillir. « Fuck, c’est une bonne idée! »

Je me suis dépêché à sortir pour ne pas faire comme avec mes 1000 autres idées qui finissent par mourir dans mon inconscient.

J’ai trouvé ça: Freenove Control Board V5.

Comme on peut voir sur l’image, il y a clairement 2 chip sur le board!

J’ai SMASH buy sans lire en me disant que j’allais regarder ça quand j’allais le recevoir. ![]()

Turns out, c’est EXACTEMENT la même chose qu’un Arduino Uno R4.

![]()

![]()

![]()

![]()

Mais attends… S’il y a 2 cpu, sans doute qu’il y a moyen de programmer les 2 de façon indépendante!

Après une petite recherche Google, je suis tombé ici.

On peut ajouter un jumper à cet endroit pour alterner entre les 2 processeurs!

Holy shit j’ai failli pleurer!

Au final, ça a été quand même compliqué et j’ai brûlé au moins 5 boards. ![]()

![]() Mais j’ai fini par faire fonctionner et je suis vraiment content parce que les changements vont faire TOUTES la différence.

Mais j’ai fini par faire fonctionner et je suis vraiment content parce que les changements vont faire TOUTES la différence.

-

Le ESP32 supporte OTA: ça veut dire que je peux faire les mises à jour à distance via wifi!!! Plus besoin de défaire le robo pour me brancher dans le port USB. Nice!!

-

Le ESP32 gère tout ce qui est communication, l’Arduino gère le contrôle des moteurs. On peut contrôler les 4 axes en même temps sans problème à partir de n’importe quel autre appareil connecté sur le réseau.

-

L’Arduino obtient sa configuration de mon serveur MQTT.

Ça veut dire que je peux activer/désactiver des fonctions et reconfigurer la caméra à distance. Une fonction assez importante si l’alternative est de faire 7h de voiture à chaque fois que je dois intervenir! ![]()

Comme on peut voir sur la capture d’écran du serveur MQTT, 2 sujets contrôlent les mouvements: « control » et « position ».

Les deux contiennent une ligne de JSON qui ressemble à ça:

{

"x": 0,

"y": 0,

"z": 0,

"a": 0

}

Dans le sujet « control », je peux publier n’importe quel chiffre entre -100 et 100. Le nombre représente la vitesse à laquelle le moteur doit bouger dans la direction. C’est le « joystick » virtuel que je vais donner à l’IA!

Dans le sujet « position », on publie les positions absolue. Pratique pour refaire exactement le même setup à chaque fois. C’est ce que mes clients utilisent lorsqu’ils veulent faire des ajustements manuels.

Bien sûr, l’interface que les gens ont au studio est beaucoup plus simple. Ils ont ça sur le panneau de contrôle:

Une fois que j’aurai installé les V3.3 des robocaméras, je vais pouvoir ajouter une switch (ON/OFF) en dessous pour activer le mode « CamérAIman » où c’est mon AI qui prend le contrôle.

Je ne suis pas encore certain des choix que je vais laisser aux gens, mais essentiellement j’ai configuré le logiciel pour qu’on puisse facilement:

-

Choisir le type de cadrage souhaité (gauche, centre, droite) et le type de plan (plein pied, buste, close up).

-

Activer/désactiver les 4 axes (pan, tilt, hauteur, zoom).

Ensuite, l’IA trace une ligne entre les yeux de la personne et calcule la vitesse et la direction à envoyer au robocaméra pour chaque angle. Il crée un petit document JSON qu’il publie 24 fois par seconde dans le sujet « control » du serveur MQTT.

{

"x": 15,

"y": 52,

"z": 12,

"a": 1

}

Le robocaméra prend la nouvelle valeur et la compare à la dernière pour calculer une courbe d’accélération. Il augmente (ou diminue) de vitesse plusieurs milliers de fois par secondes jusqu’à ce qu’il ait atteint sa cible (ou qu’il ait reçu une nouvelle commande).

Bref, pretty cool stuff! Ce n’est pas parfait (on peut facile « s’échapper » du tracking de la caméra en bougant rapidement), mais ça va être parfait pour l’usage qu’on va en faire!

Tl;DR J’ai passé les 3 dernières années à apprendre la robotique pour enlever 10 min de gossage à mes clients. You’re welcome. ![]()

À travers tout ça, c’est facile de perdre l’objectif de vue. Il ne faut pas méprendre l’arbre pour la forêt! L’objectif principal derrière cette aventure est de réduire le temps d’apprentissage requis pour tourner des vidéos parfaites.

J’ai écrit dans le premier post du sujet:

Aujourd’hui, on est rendu à ~ 2h30. 45min première rencontre, 60min formation au studio. 45min de support over time. Au final, mes clients sont beaucoup plus satisfaits et restent abonnés plus longtemps. L’effort en vaut la peine!

Ceci étant dit, on est encore loin de l’objectif:

La chose la plus importante pour Les Bunkers, ce sont ni mes gadgets, ni mes talents de vidéaste.

La chose la plus importante, c’est l’expérience utilisateur. Mes robots et autres inventions ne sont qu’un moyen d’affecter l’UX (pour le meilleur… ou pour le pire!)

Chaque action est en fonction d’une chose: réduire le nombre d’actions requises, tout en conservant les fonctionnalités importantes pour mes clients.

J’ai réussi à faire 80% du travail, mais, comme dans tous les projets, c’est toujours le dernier 20% qui est difficile!

Pour me rendre à la ligne d’arrivée, c’est important de n’avoir qu’une seule interface à prendre en main pour gérer le studio et cette interface doit être le plus simple possible.

À ce jour, les gens doivent encore se familiariser avec vMix, ce qui est suffisant pour en décourager plusieurs.

Ensuite, les gens doivent apprendre à monter/baisser la caméra centrale. Le téléprompteur est sur un trépied qui permet le pivot vertical et ce dernier se situe sur un standing desk.

Voici quelques petits screenshots de ma documentation pour vous aider à comprendre les manipulations à faire:

Ensuite, j’ai toujours des questions en lien avec l’usage du téléprompteur. C’est assez simple puisqu’il ne suffit que drag and drop l’application web (celle-ci) d’un écran à l’autre.

Ceci étant dit, ce n’est pas tout le monde qui est habitué de travailler à plusieurs écrans!

Même principe avec le transfert de fichier, 50% de mes clients utilisent normalement MacOS. Ça peut paraître ridicule pour les gens qui sont habitués, mais si on n’a jamais utilisé Windows de sa vie, transférer ses fichiers n’est vraiment pas si intuitif que ça!

Of course, j’ai un plan pour adresser chacun de ces points:

-

Se débarasser de vMix.

-

Robotiser la caméra principale.

-

Simplifier l’usage du prompteur.

-

Automatiser le transfert de fichiers.

Mais avant, j’aimerais faire un petit recap de ce que j’ai réussi à automatiser jusqu’à présent. Certains points ont été détaillés dans mes posts précédents alors je vais passer vite, mais j’ai ajouté 2-3 nouvelles bébelles cool qui valent la peine d’être présentées!

C’est assez technique alors j’ai rendu ça facile à skipper pour ceux à qui ça donne mal à la tête!

La console de son

Avant, on utilisait des RodeCaster Pro.

Alors que c’est une machine incroyable, le fait qu’on puisse contrôler le son sur un appareil physique ET sur vMix était vraiment problématique.

J’ai donc opté pour des interfaces Dante.

En plus de pouvoir gérer le gain, phantom power et le reste à distance, ça donne aussi beaucoup plus de flexibilité pour ajouter des micros plus tard! Le studio de Québec a maintenant 7 micros et ceux de Sherbrooke et Montréal en ont 6.

Il ne suffit que d’acheter une 2e interface, la brancher dans la même switch réseau et le tour est joué!

Bon, ça demande de l’équipement réseau spécial et ça augmente les coûts, mais ça reste la meilleure solution pour mon type de studio.

Les lumières

Chaque compagnie de lumières a son app! C’est l’enfer.

J’avais trouvé une compagnie qui permettait de contrôler les lumières via une seule manette. Elle était un peu compliquée, mais c’était ce que j’avais trouvé de mieux à l’époque.

Ceci étant dit, c’était l’enfer… Tout le monde DÉTESTAIT jouer avec les lumières. Le setup était différent à chaque fois et c’était impossible pour moi de contrôler à distance.

Les « pro » utilisent un protocole qui s’appelle DMX. Sauf qu’une console DMX ressemble à ça:

Oublie ça, mes ginettes vont faire une syncope!

J’ai fini par trouver un truc qui s’appelle ARTNET. Essentiellement, ça permet de contrôler un univers DMX par le réseau.

C’est ce qui m’a permis de créer cette interface de gestion:

Ce n’est pas 100% intuitif, dans le sens qu’on doit catcher que:

Intensité = force

Saturation = intensité de la couleur

HSI = Couleur sur le cercle chromatique

Je pourrais peut-être tweaker les choses un peu, mais je n’ai aucun commentaire négatif de mes clients alors ça passe le test du « good enough » pour moi!

Le plus cool dans tout ça, c’est que ça me permet de:

-

Toujours remettre les lumières dans le même état lorsque les gens entrent dans le studio.

-

Créer des presets jolis que les gens peuvent activer en un seul bouton. (À droite sur l’image)

-

Permettre à mes clients d’enregistrer l’état du studio dans leur propre preset. (À gauche sur l’image)

Ce qui est encore plus cool, c’est que les presets enregistrent également l’état des robocaméras!

Quand on rentre, le studio applique automatiquement le preset #1 du client. Comme ça, mis-à-part la caméra du centre et la position du bureau, son expérience est identique d’une fois à l’autre!

Les toiles de fond

Bon, un peu de nouveau!

En janvier dernier, je suis tombé sur ces moteurs-là:

Avant, je me serais dit « ahhhh c’est plate. Il n’y a pas d’intégration wifi ou autre! ».

Maintenant, avec mes nouveaux skills d’apprenti ingénieur, je me suis dit: hey, c’est juste un moteur DC! Je branche ça dans un p’tit contrôleur avec un ESP32 et le tour est joué. ![]()

Alors j’en ai commandé 9.

Fast-forward 2 mois plus tard, voici à quoi ressemble mon contrôleur.

(J’ai pris la photo avant de finir le branchement.)

Bien sûr, le couvercle est par-dessus une fois installé. ![]()

J’ai brûlé un tas de board avant d’avoir quelque chose de fonctionnel, mais le résultat est super!

Ça me permet d’ajouter ça dans l’interface que les gens utilisent pour gérer le studio:

Et ça contrôle les toiles comme par magie! ![]()

La caméra de face

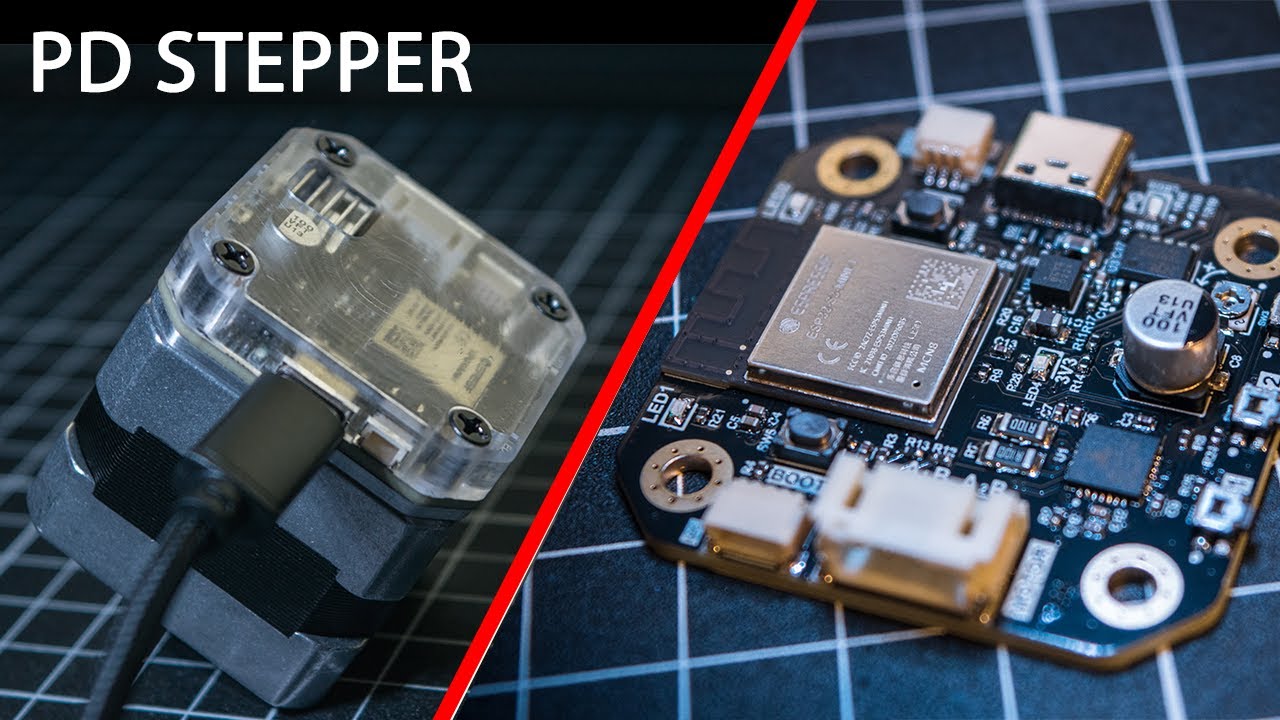

Il y a quelque temps, je suis tombé sur ce projet-là:

Ma 1e réaction à été de me dire: damn, j’aimerais ça apprendre à faire mes propres PCB.

Ma 2e réaction a été de SMASH BUY sur son truc. Je n’avais aucune idée de ce que j’allais faire avec, mais j’avais confiance que ça allait finir par servir.

Pour le monde normal, ce truc-là permet de contrôler un moteur Nema17 super facilement. Tout ce que ça prend, c’est un câble USB. Tout est built-in dans le package!

Bref, c’est malade!

C’est quoi le rapport avec la caméra de face? Tu vas voir!

J’ai eu quelques problèmes avec mes caméras centrales. Les lentilles que j’utilise sont normalement des Prime avec une ouverture rapide (f1.8/2) pour être capable d’avoir un beau flou d’arrière-plan.

(Plus le « f » est bas, plus ça laisse rentrer de lumière, plus le flou d’arrière-plan est prononcé.)

Figure-toi donc que c’est arrivé à plusieurs reprises que des clients décident de tourner le premier anneau de la lentille pour essayer de zoomer/dé-zoomer.

Si tu fais de la photo, tu te dis sans doute « ohhhhhh shit… ![]() C’est pas un zoom ça! »

C’est pas un zoom ça! »

En effet, ça contrôle l’ouverture (le « f »), pas le zoom! ![]()

Voici un scénario typique:

-

Le client tourne le truc, se dit « ça fait rien ça esti ».

-

Il continue de filmer sans réaliser son erreur.

Résultat? Sa vidéo est BEAUCOUP trop claire (ou sombre) et il faut que quelqu’un m’en avise pour que je puisse guider un client à travers les étapes pour rétablir ça correctement.

C’est déjà arrivé qu’une des caméras reste déréglée pendant 2 semaines! Une bonne dizaine de personnes ont utilisé le studio avant que quelqu’un réalise qu’il y avait un problème et me texter « eille, la caméra de face est sombre, what’s up with that? »

Je sais… C’est un peu tannant. J’ai beau l’écrire à 100 endroits, beaucoup de clients ne font aucun test (de son ou d’image) avant de commencer à enregistrer. Encore pire, ils ne vérifient souvent pas leur vidéo avant plusieurs semaines.

![]()

![]()

Je trouve ça dommage, mais bon, c’est une autre raison pourquoi je dois continuer de travailler fort pour éliminer toutes les exceptions et opportunités de faire une fausse manipulation. ![]()

Bref, de retour à notre caméra principale.

J’ai reçu mon PD Stepper 6 mois plus tard. Je ne savais pas trop quoi faire avec jusqu’à ce que l’incident se produise.

Je me suis dit: « Si le monde veulent zoomer tant que ça, j’ai juste à leur mettre une zoom lens esti! »

J’ai acheté des Sigma 28-70mm F2.8 DG DN et j’ai mis le PD Stepper dessus et j’ai adapté ça avec mon système de Robocaméras.

Ce qui permet de faire:

Tout ça via ce bouton dans l’interface:

Ça fait pas mal le tour de ce que j’ai fait jusqu’à présent! C’est maintenant le temps de te parler de mon masterplan pour la prochaine année.

J’ai mentionné avoir comme objectif que je voulais:

-

Se débarasser de vMix. Tout consolider dans une seule interface.

-

Robotiser la caméra principale.

-

Simplifier l’usage du prompteur.

-

Automatiser le transfert de fichiers.

Voici l’expérience que je vise offrir une fois que tout va être en place…

The end game.

Tu entres au studio, vMix s’ouvre à l’arrière plan et le studio charge ton preset. (Si c’est ta première fois, on applique une configuration générique.)

Voici ce que tu vois sur l’écran:

Une fois le disque branché, on passe au menu suivant:

Elle doit débuter par ajuster les lumières. Cette étape est optionnelle si la personne est satisfaite avec les configurations par défaut (ou qu’elle a déjà enregistré son preset).

Par la suite, on va dans l’interface d’enregistrement. Sur cette page, on peut:

-

Choisir son micro.

-

Activer / désactiver le retour de son des micros dans les écouteurs. (Pour faire son test de son)

-

Contrôler le téléprompteur.

-

Contrôler un navigateur web.

-

Choisir ce qui apparaît sur la télévision entre un quadrillé des 4 caméras et la caméra « active ».

-

Ajuster les angles de caméra, activer/désactiver l’IA.

-

Donner un nom au projet et à la vidéo.

-

Enregistrer la vidéo.

Si la personne est en mode CamerAIman, les contrôles manuels vont disparaître pour sauver de l’espace. Je vais mettre une p’tite switch on/off quelque part!

Finalement, il y a la page d’aide:

J’ai créé un paquet de scripts qui me permettent de déboguer en cas de problème. Soit que ça lance des scripts sur Windows, soit que ça ferme/ouvre des petites prises intelligentes pour faire un « power cycle » de l’appareil.

L’idée est que 100% de l’expérience passe par cette interface. Elle va être en plein écran et ça va être impossible de la fermer.

Par contre, je suis conscient que ça ne sera pas parfait au début. Je vais donc ajouter un bouton « mode avancé » qui va fermer l’interface et redonner le contrôle à l’utilisateur.

Transfert de fichier automatisé

Tu vas te douter qu’il y a une raison derrière la nouvelle obligation de brancher son disque dur pour commencer à enregistrer.

Présentement, les gens doivent brancher leur disque dur et faire le transfert eux-même.

Résultat? Ils le font à la fin et ça arrive qu’il déborde sur la réservation d’après. Non seulement ça, mais un client sur deux oublie de supprimer ses fichiers avant de partir, ce qui est un peu gossant pour le client d’après.

En forçant les gens à brancher leur disque dur dès le départ, ça va me permettre d’exécuter un script à la fin de chaque enregistrement qui va…

-

Renommer tous les fichiers au format

{nom-du-projet}__{nom-de-la-video}__{source}__YYYY-MM-DD__HH:MM:SS.mp4 -

Créer le dossier /{nom du projet}/{nom de la vidéo} sur le disque dur de la personne et y transférer les fichiers.

-

Faire un checksum sur les deux fichiers pour s’assurer qu’ils sont identiques et supprimer la copie locale.

Les sources (la variable dynamique dans le nom du fichier) vont être:

-

Caméra du centre

-

Caméra de gauche

-

Caméra de droite

-

Caméra du dessus

-

Caméra Active

-

Audio Stereo

-

Audio Multitrack

Robotiser la caméra centrale

Les gens bougent toujours la caméra de face. Ça fait qu’elle pointe parfois trop à droite ou trop à gauche. Qu’elle est trop haute ou trop basse, etc.

L’enjeu que j’ai avec cette caméra est qu’elle doit supporter:

-

La télévision

-

Le téléprompteur + la caméra

-

L’ordinateur

Comme j’ai mentionné plus tôt, on utilise présentement un standing desk.

J’ai donc le choix de:

-

Trouver une façon de me brancher avec le contrôleur du standing desk, créer une plateforme qui me permet de contrôler l’axe vertical et visser le tout dans la table.

-

Faire un genre de système sur mesure.

J’y médite… Le truc custom est plus clean, mais le standing desk pimpé va être plus rapide!

Conclusion

Si tu m’as lu jusque ici, holy crap! Are you okay?

Sans farce, merci pour ton intérêt. ![]() N’hésites pas si tu as des questions/commentaires/objections ou suggestions!

N’hésites pas si tu as des questions/commentaires/objections ou suggestions!

L’objectif de base est ambitieux et je me suis un peu lancé sans savoir de quoi je parlais. Par contre, je sens que je suis de plus en plus près d’un système parfaitement intégré. Cette technologie, une fois prête, va me permettre de complètement redéfinir mon entreprise.

En fait, ça ouvre la porte à explorer un nouveau modèle d’affaires: le licensing.

Les studios gardent leur brand, prix, services, etc… mais utilisent mon système pour automatiser leurs opérations.

De cette façon, tous les « studios » vont avoir la même expérience d’enregistrement, ce qui ouvre la porte à créer un portail de réservation unifié!

Le client s’abonne aux Bunkers et obtient des jetons. Il peut ensuite réserver dans n’importe quel studio. De mon côté, je paies les gens qui utilisent mon système à chaque fois qu’un client des Bunkers utilise leur studio.

Win/win/win

Check mate. 4D chess masterplan.